Architecture Ampere

L’architecture Ampere représente la deuxième génération de cartes graphiques RTX. Celle-ci améliore de l’ordre de 1,9 fois les performances par Watts comparativement à l’architecture précédente Turing. Voyons plus en détail comment cela a été réalisé. Nous avons un GPU GA102-200 de chez Samsung avec une finesse de gravure de 8 nm et 28 millions de transistors sont présents. Nous avons un TGP de 320 W et l’alimentation se fait en 2*8-pins. Mais avant de partir dans les détails, refaisons le point également sur les caractéristiques des RTX 30 Series face à la RTX 2080 Ti. Notez qu’il s’agit ici des spécifications des Founders Edition. Les fréquences GPU varient sur les références customs.

| RTX 3090 | RTX 3080 | RTX 3070 | RTX 2080 Ti | |

|---|---|---|---|---|

| GPU | 8nm GA102-300 | 8nm GA102-200 | 8nm GA104-300 | 12nm TU102-300 |

| Die Size |

628 mm2

|

628 mm2

|

392 mm2

|

754 mm2

|

| Transistors |

28 B

|

28 B

|

17.4 B

|

18.6 B

|

| Board | PG132 SKU 30 | PG132 SKU 10 | PG142 SKU 10 | PG150 SKU 32 |

| CUDA Cores |

10 496

|

8 704

|

5 888

|

4 352

|

| Tensor Cores |

328 (4 par SM)

|

272 (4 par SM)

|

184 (4 par SM)

|

544 (8 par SM)

|

| RT Cores |

82

|

68

|

46

|

68

|

| Base Clock |

1395 MHz

|

1440 MHz

|

1500 MHz

|

1350 MHz

|

| Boost Clock |

1695 MHz

|

1710 MHz

|

1725 MHz

|

1545 MHz

|

| Shader Perf. |

35.6 TFLOPS

|

29.8 TFLOPS

|

20.3 TFLOPS

|

13.4 TFLOPS

|

| RT Perf. |

285 TFLOPS

|

283 TFLOPS

|

163 TFLOPS

|

110 TFLOPS

|

| Memory |

24GB G6X

|

10GB G6X

|

8GB G6

|

11GB G6

|

| Memory Clock |

19.5 Gbps

|

19 Gbps

|

14 Gbps

|

14 Gbps

|

| Memory Bus |

384-bit

|

320-bit

|

256-bit

|

352-bit

|

| Bandwidth |

936 GB/s

|

760 GB/s

|

441 GB/s

|

616 GB/s

|

| TDP |

350W

|

320W

|

220W

|

250W

|

| MSRP |

1549 euros

|

719 euros

|

519 euros

|

1259 euros

|

Processeur de Streaming

L’un des aspects les plus importants de l’architecture Ampere repose sur les processeurs de streaming, alias les SM (streaming multiprocessors). Comparativement à la génération précédente sur Turing, les nouveaux SM offrent un double de performances en FP32. Sur une RTX 3080 on dispose de 68 SM contenant chacun 4 Tensor Cores. On obtient donc les 272 Tensor Cores. Sur le schéma ci-dessous on peut voir de quoi est constitué un SM. On peut y voir les 4 Tensor Cores, mais également que chaque unité dispose de 32 cœurs FP32 ((32*4)*68) = les 8704 cœurs CUDA. Notez que parmi les 32 cœurs présents dans chacune des quatre unités qui composent un SM, 16 d’entre eux peuvent effectuer simultanément des calculs INT32.

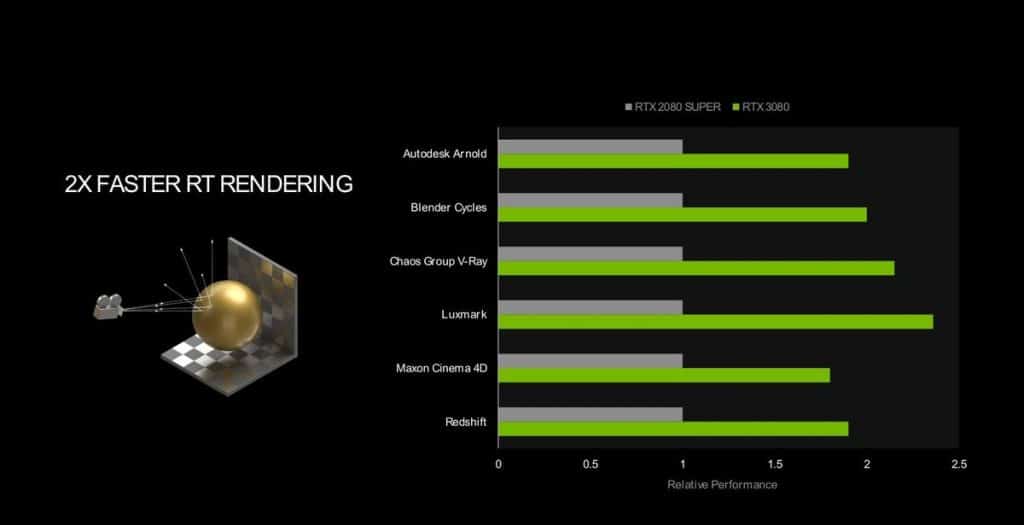

RT Cores et Tensor Cores

On remarquera que le nombre de RT Cores est identique à la RTX 2080 Ti, mais il faut prendre en compte que l’IPC a augmenté de 1,7x. La technologie Ray Tracing utilise tout spécifiquement ces cœurs. Pou rappel, cette technologie qu’on appelle aussi souvent « RTX » consiste à traiter la lumière en temps réel dans les jeux pour apporter du réalisme avec des ombres, reflets, etc. Cela dans un niveau qui n’est pas possible de faire manuellement, ou en prenant beaucoup trop de temps. Le « problème » de cette technologie est qu’elle est très consommatrice en ressources et la chute des FPS est inévitable. Pour palier à cela, les Tensor Cores entrent en jeux pour la technologie DLSS (Deep Learning Super Sampling). Le DLSS repose sur un réseau neuronal d’apprentissage (une IA) qui permet d’augmenter les FPS en jeux via un procédé qui maintient, voire améliore même la qualité d’image dans certains cas. Ces Tensor Cores sont issues de la troisième génération et bénéficient d’un IPC augmenté de 2,7 fois comparativement à l’architecture précédente. C’est aussi cette technologie qui permet, entre-autres, de jouer jusqu’en 8K avec une RTX 3090 via un mode Ultra Performance.

Mémoire Micron GDDR6X

Est inaugurée avec cette génération la mémoire GDDR6X de chez Micron qui est la mémoire la plus rapide actuellement. La GDDR6X utilise la technologie de transmission de signal PAM4 pour doubler le débit de données par horloge en offrant des performances de mémoire graphique record pour alimenter les charges de travail les plus gourmandes en données comme les jeux, la visualisation professionnelle et l’inférence IA. Ces améliorations garantissent que les cœurs de calcul du GPU et les autres composants reçoivent un flux constant de données plutôt que de se bloquer dans une file d’attente, maximisant ainsi l’efficacité et les performances.

Sur cette carte, nous retrouvons 10 Go de mémoire de type GDDR6X, la bande passante mémoire atteint une bande passante de 760 Gb/s (596 pour la RTX 2080 SUPER) avec un bus à 320-bits. Tout ceci participe à améliorer les performances par Watts de 1,9x par rapport à l’architecture Turing.

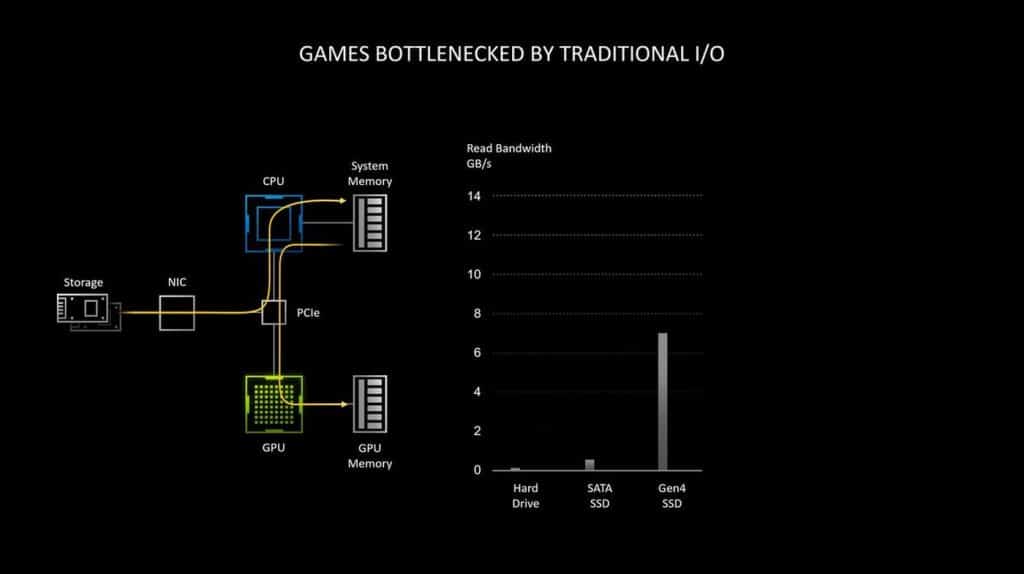

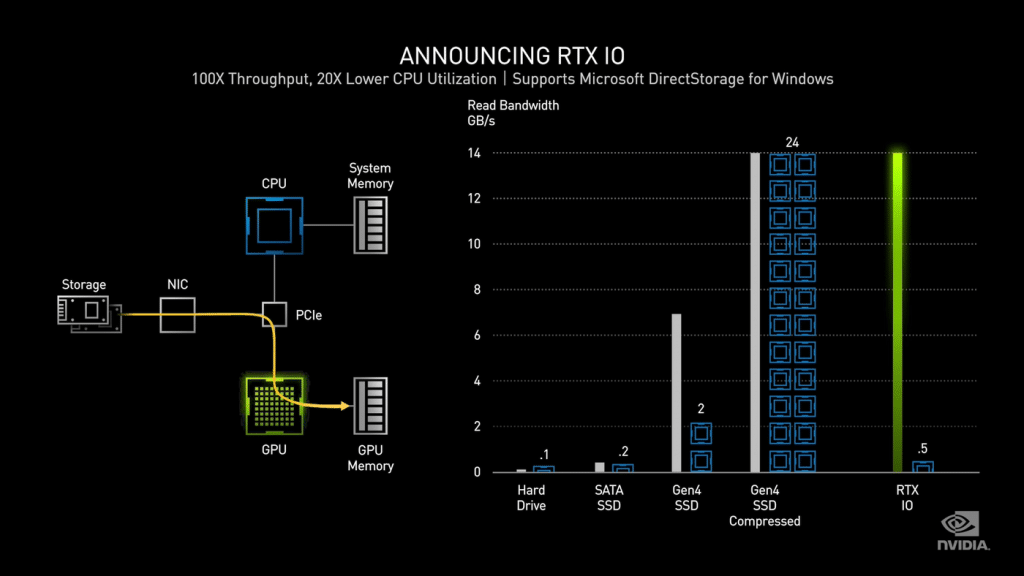

RTX IO

Avec tout ceci, NVIDIA introduit de nouvelles technologies comme RTX IO. Celle-ci est une nouvelle architecture de stockage. Concrètement, jusqu’à présent la carte graphique communiquait avec le stockage via le processeur et la mémoire système. Cette charge étant de plus en plus forte sur le processeur; il peut y avoir un impact visible sur les performances, NVIDIA arrange la situation en faisant communiquer la carte graphique directement avec le stockage sans intermédiaire ce qui permet d’accélérer les débits. RTX IO apporte une décompression de données sans perte accélérée par GPU, ce qui signifie que les données restent compressées et regroupées avec moins d’en-têtes d’E/S, car elles sont déplacées du disque vers le GPU. NVIDIA annonce que cela permet de saturer la bande passante du PCIe 4.0 en atteignant le cap de 14 Go/s. À titre de comparaison, le système présenté sur la console de salon PlayStation 5 qui a fait beaucoup de bruit est à 9 Go/s.

À noter que cette technologie est annoncée comme compatible avec les cartes graphiques basées sur Turing également (RTX 20 Series). Cela se fera via de prochaines mises à jour. Il faut aussi prendre en compte qu’un SSD PCIe 4.0 n’est pas obligatoire pour profiter de RTX IO. En effet, même avec un SSD NVMe en PCIe 3.0 cela fonctionne, il faut simplement se dire que plus le SSD sera rapide, plus les débits seront élevés et les temps de chargement courts dans les jeux.

Selon les tests de NVIDIA, la lecture de données non compressées à partir d’un SSD à 7 Go/s comme le Samsung 980 Pro, nécessite l’utilisation complète de deux cœurs de processeur. Puis le système d’exploitation répartit cette charge de travail entre les cœurs et threads disponibles. Le problème est que pour un jeu triple A récent, des centaines de milliers de ressources individuelles sont entassées dans ds fichiers compressés.

Bien qu’au niveau d’E/S du disque, les uns et les zéros soient toujours déplacés jusqu’à 7 Go/s, le flux de données décompressé au niveau du processeur peut atteindre 14 Go/s dans le meilleur des cas. Ajoutez à cela le fait que chaque demande d’E/S arrive avec sa propre surcharge : un ensemble d’instructions permettant au CPU de récupérer x éléments de ressource du fichier y et le livrer au tampon z, le tout avec des instructions pour décompresser ou décrypter la ressource. Cela pourrait prendre énormément de puissance au processeur à une échelle de débit IO élevée, et NVIDIA fixe le nombre de cœurs de processeur requis à 24. C’est l’API DirectStorage qui permet aux périphériques de traiter directement la pile de stockage pour accéder aux ressources dont ils ont besoin. Notez aussi que l‘API de Microsoft a été initialement développée pour la Xbox Series X, mais elle fait maintenant ses débuts sur la plate-forme PC. Cela veut dire en revanche que les jeux doivent être optimisés pour cet API. Si on prend en compte le fait que cette technologie est déjà utilisée sur Xbox, les jeux existants sur la console et portés sur PC ont déjà quelques optimisations pour l’API, mais devront tout de même voir quelques modifications apportées pour être bien supportées sur PC.

Pour les cartes graphiques, on s’attend à ce que seules les RTX le prennent en charge, y compris la génération précédente reposant sur Turing.

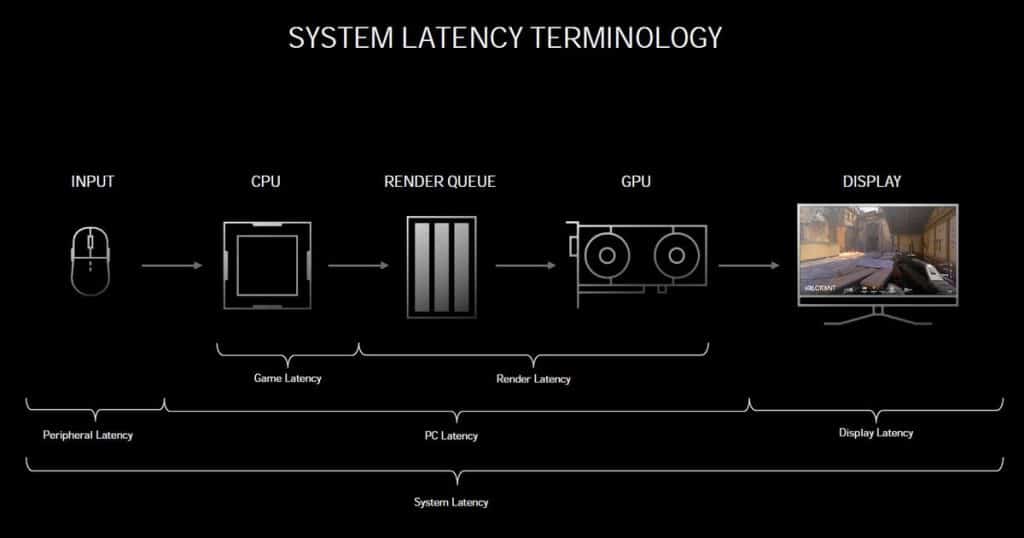

NVIDIA Reflex et Latency Analyzer

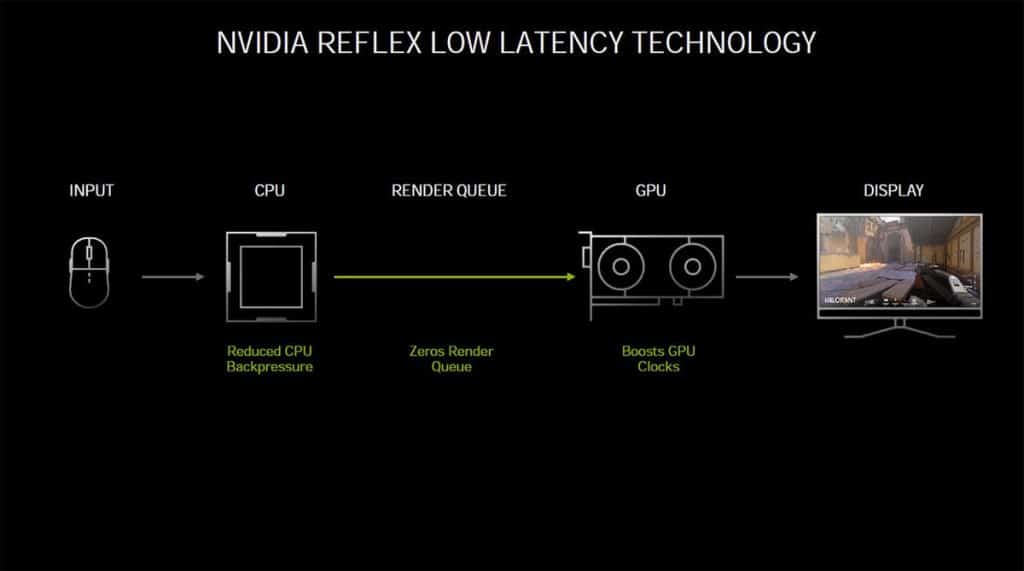

Durant l’annonce de cette génération de GPU, NVIDIA a également présenté la technologie Reflex. Celle-ci permet de réduire la latence des jeux (esports notamment) jusqu’à 50 %. Les premiers jeux prenant en charge NVIDIA Reflex sont Valorant, Apex Legends, Call of Duty Warzone, Destiny 2 et bien sûr Fortnite. Les développeurs disposent d’APIs fournies par NVIDIA pour l’intégrer dans leurs jeux. Du côté des utilisateurs cette technologie arrivera sous forme d’une mise à jour via les pilotes GeForce. Notez que cela ne fonctionne pas uniquement sur les nouvelles RTX 30 Series, mais à partir des GTX 900, un aspect important à souligner. Pour rappel, la latence représente le laps de temps entre l’action, par exemple un clic sur la souris et le moment où l’action est affichée à l’écran.

Niveau fonctionnement, le pilote travaille de concert avec le moteur du jeu pour optimiser la pipeline du rendu 3D. La file d’attente de rendu est donc réduite dynamiquement et moins d’images sont en file d’attente. NVIDIA déclare que cette technologie permet de garder le GPU parfaitement synchronisé avec le CPU (file d’attente de rendu 1: 1).

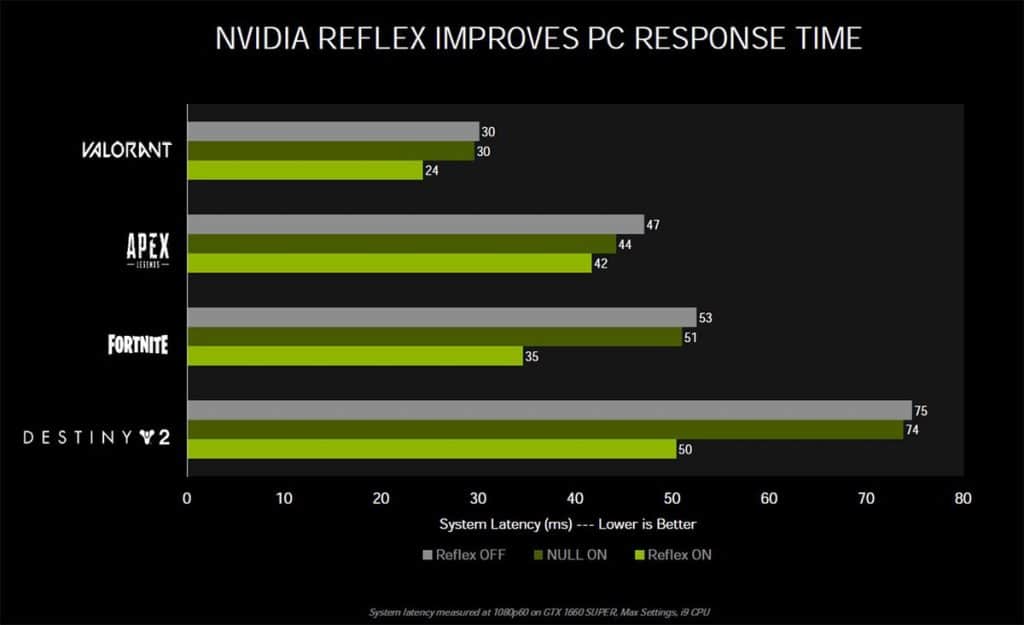

Sur le graphique ci-dessous, NVIDIA montre l’efficacité de sa technologie Reflex. Notez que sur la configuration de test il s’agit seulement d’une GTX 1660 SUPER avec un processeur Intel Core i9, le tout avec une définition 1080p. Dans les quatre jeux présentés, tous en profitent dans des mesures plus ou moins grandes.

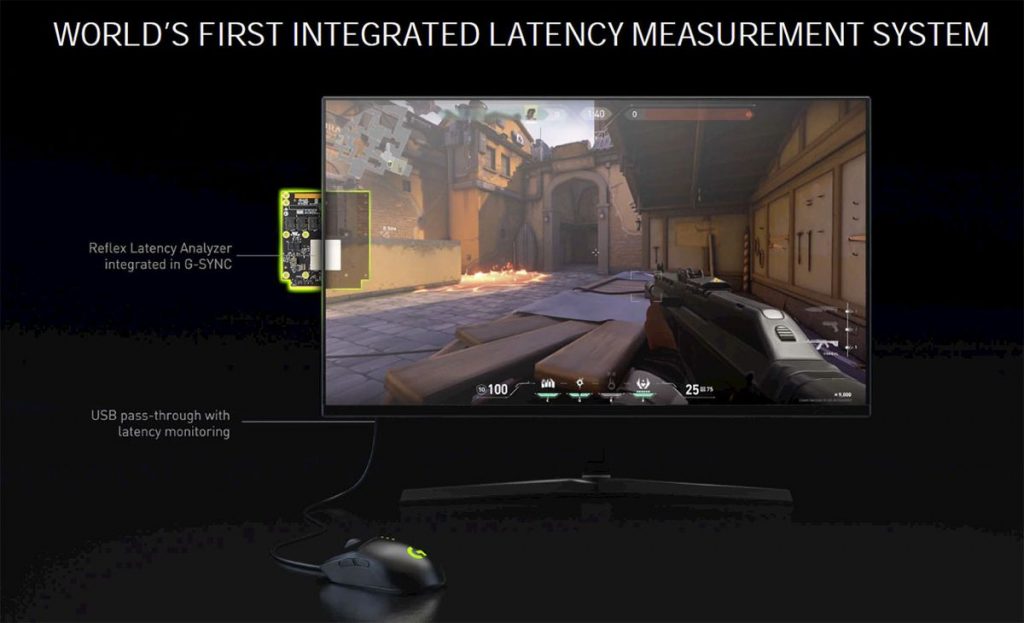

Avec NVIDIA Reflex, la marque a présenté un nouveau standard pour les moniteurs Esports : les écrans G-Sync 360 Hz avec la technologie NVIDIA Reflex Latency Analyzer. Cette dernière est intégrée via le module G-Sync de l’écran et permet de mesurer la latence d’un écran, d’une souris et du PC dans un jeu. Accompagnés d’un taux de rafraîchissement à 360 Hz qui réduit déjà naturellement l’input lag, ces écrans garantissent des latences particulièrement basses, idéales pour les jeux esports. De plus, cette prouesse ne repose pas sur des dalles de types TN qui sont généralement les plus rapides, mais sur des dalles de types IPS qui ont de bien meilleurs rendus.

Sur les écrans G-Sync 360 Hz se trouvent un HUB USB contenant deux ports USB. On peut y brancher n’importe quel périphérique, mais c’est aussi là qu’il faudra brancher la souris certifiée NVIDIA pour profiter des fonctionnalités supplémentaires. Une fois branché la fonctionnalité s’activera depuis l’OSD de l’écran et à chaque action de la souris sa latence sera mesurée et affichée. De même, la latence du système complet est mesurée. Ci-dessous une petite vidéo illustrative de Nvidia Reflex.

Passons à la suite et commençons à regarder les performances de cette carte GIGABYTE RTX 3080 GAMING OC 10G.

Lire la suite

- Introduction et caractéristiques techniques

- Architecture Ampere

- Overclocking & benchmarks logiciels

- Benchmarks jeux vidéos

- Test PCIe 4.0 VS 3.0

- Températures, consommations, performances par Watts et latence

- Conclusion

- Shooting photo complet

Vous n’avez pas parlé du bruit généré par la carte graphique. Laquelle est la plus silencieuse entre la Asus Tuf 3080 et la GIGABYTE RTX 3080 GAMING OC 10G ?

Bonjour,

Effectivement je n’ai pas parlé du bruit puisqu’il y avait en permanence beaucoup trop de bruit dans la pièce pour que les relevés soient représentatifs. Ensuite, d’un point de vue purement subjectif j’ai trouvé la carte très silencieuse durant les benchmarks. Si quelque chose m’avait interpellé durant les tests, j’en aurais fait part dans l’article.

Il me semble que vous indiquez les mesures de la carte Asus TUF, car elles sont les mêmes aux mm près.

KitGuru donne les dimensions suivantes pour la Gigabyte: 32cm x 13cm x 5.5cm

Cette carte risque de ne pas passer dans certains boitiers mATX.

Effectivement petite erreur, merci de l’avoir notifié je viens de mettre le tableau à jour !

Bonjour,

Très bon test, merci pour les benchmarks, par contre aucune photo avec la backplate d’enlevée ou c’est moi qui l’ai loupé ? Avec la polémique sur les capaciteurs utilisés sur le 3080/3090 en ce moment ça peut intéresser les gens. Autre remarque mais moins importante : aucun graphique ou au moins valeur max. de fréq. GPU atteinte pendant les tests.

Ça fait plaisir de voir un site FR à la hauteur !