Nous le voyons dans l’actualité ces dernières semaines, depuis la démocratisation de ChatGPT, l’IA est évoqué par tout le monde et cela dans tous les domaines d’activités. Après NVIDIA qui annonce que dans 10 ans les performances de l’IA aura encore augmentés de l’ordre d’un million de fois, aujourd’hui on a apprend via un rapport de TrendForce qu’il s’agit d’un domaine d’activité dans lequel NVIDIA va avoir une belle place au soleil. En effet, la demande de puce de chez NVIDIA devrait augmenter de 30 000 unités par an, uniquement pour accroitre l’IA dans les entreprises travaillant avec. NVIDIA a donc de quoi se frotter les mains.

Une demande en hausse de 30 000 GPU par an grâce à la course à l’IA

En effet, la demande autour de l’IA vit un bond spectaculaire depuis la mise à disponibilité de ChatGPT par OpenAI au grand public. Dorénavant, les plus grosses entreprises et navigateurs web se battent pour proposer leurs IA (Meta, Microsoft, Google, etc.). Ces entreprises se sont donc lancées dans une course pour dominer le marché et ne pas se laisser dépasser et ainsi perdre des parts de marché avec ce nouveau tournant technologique d’ampleur.

Précisons tout de même qu’il n’y a pas seulement NVIDIA qui se frotte les mains avec cette demande qui va grandir, mais TSMC, Unimicron ou encore AIChip sont aussi impactés pour leur plus grand bonheur. Si pour le moment cette évolution peut faire peur avec tous les films de science-fiction qui traitent du sujet de l’IA qui se retourne presque systématiquement contre l’homme, sachez qu’OpenAI a appelé à une réglementation de l’IA. Des choses devraient bouger de ce point de vue pour encadrer la chose et les dérives éventuelles.

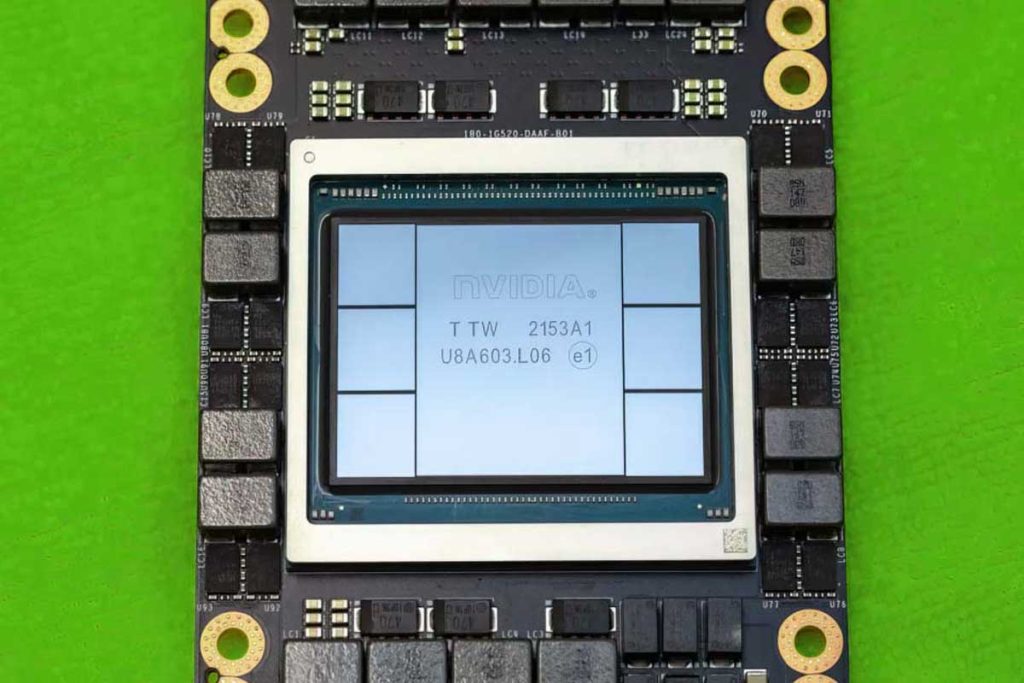

Mais si les entreprises ont besoin de plus de puces, c’est parce qu’une IA peut travailler sur des tâches spécifiques après un entrainement : le Deep Learning. C’est justement cette tâche qui nécessite des puces. En 2018, ChatGPT utilisait 120 millions de paramètres pour faire fonctionner son IA, en 2020 ce nombre est passé à 180 millions et cela explique la puissance de traitement demandé pour entrainer une IA. En effet, aujourd’hui nous serions déjà à 250 millions de paramètres. En 2020 et pour les 180 millions de paramètres, il était nécessaire d’avoir pas moins de 20 000 GPU. Cette année, on s’attend donc à une demande passant à 30 000 GPU. TrendForce parle ici des GPU A100 de NVIDIA.

Ces GPU NVIDIA A100 sont basés sur l’architecture Ampere et ont une puissance brute de 19,49 TFLOPS en FP32. Aujourd’hui, nous avons les GPU H100 qui passent à 51 TFLOPS de puissance brute. Ainsi, avec 30 000 GPU H100 plutôt que A100 – ou les deux mélangés – nous pouvons entrevoir une augmentation considérable de la puissance de traitement. Pour information, un GPU NVIDIA H100 est tout de même vendu environ 8000 dollars pour un système MXM. Un DGX avec des GPU H100 vaut plus de 35 000$.

AMD est aussi dans la partie avec ses GPU MI300, mais NVIDIA a un train d’avance au niveau des API, applications, mais surtout globalement avec son écosystème plus au point.

Concrètement, l’année 2023 devrait être très bénéfique pour l’entreprise au caméléon. AMD et Intel vont mettre les bouchés doubles pour se faire une place au soleil.