NVIDIA a récemment annoncé le lancement de son propre chatbot, baptisé « Chat With RTX« . Ce qui le distingue des autres, c’est qu’il ne peut être utilisé que sur des ordinateurs Windows 11 dotés de la bibliothèque TensorRT-LLM. En d’autres termes, ce chatbot s’exécute localement avec les Tensor Core de votre GPU NVIDIA GeForce RTX. Cela veut dire une chose : seuls les heureux propriétaires de cartes RTX 3000 et RTX 4000 pourront taper la causette avec Chat With RTX !

Chat With RTX de NVIDIA : comment ça marche ?

En effet, toutes les cartes sous les RTX 3000 n’ont pas ce qu’il faut physiquement pour que le chatbot de NVIDIA puisse fonctionner, exit donc les RTX 2000 et même les GTX.

La démonstration technologique de Chat with RTX est basée sur le projet de référence pour les développeurs TensorRT-LLM RAG disponible sur GitHub. Les développeurs peuvent utiliser cette référence pour développer et déployer leurs propres applications basées sur RAG pour RTX, accélérées par TensorRT-LLM.

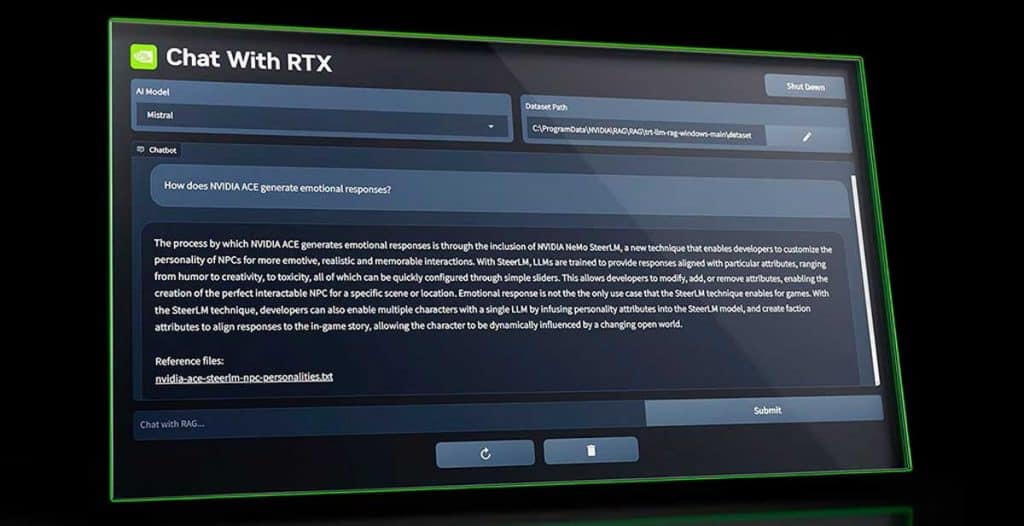

Si vous n’avez pas le temps de regarder la vidéo, concrètement Chat With RTX vous permet d’avoir votre propre chatGPT avec un modèle de langage LLM personnalisé. La démonstration, accélérée par TensorRT-LLM, permet aux utilisateurs d’interagir rapidement avec leurs notes, documents et autres contenus. Il sera également disponible en tant que projet de référence open source permettant ainsi aux développeurs d’implémenter facilement les mêmes capacités dans leurs propres applications.

À quoi cela sert-il réellement ? Une fois téléchargé et installé sur votre PC, Chat with RTX peut lire tous les documents de votre PC (.txt, .pdf, .doc, .docx, .xml) et les connecter à un modèle de langage large tel que Mistral et Llama 2. Cela vous permettra de réaliser des travaux, de résumer ou de simplifier des informations, entre autres exemples. Ces documents peuvent être complétés par des URL spécifiques pour améliorer encore plus la précision des informations.

Vous pouvez également ajouter l’URL d’une vidéo YouTube et lui demander des informations spécifiques sur ce qui est abordé dans cette vidéo. Idéal si elle n’est pas traduite dans votre langue et que vous ne la comprenez pas ou si c’est une vidéo longue et que vous souhaitez qu’elle vous résume toutes les informations qu’elle contient par manque de temps.

Voici les exigences auxquelles votre PC doit répondre pour exécuter cette technologie

Les exigences pour utiliser Chat with RTX de NVIDIA incluent Windows 11 ainsi que les pilotes graphiques NVIDIA GeForce 535.11 WHQL ou ultérieurs. Au niveau matériel, vous aurez besoin de 16 Go de RAM et d’une carte graphique GeForce RTX 40 ou RTX 30. Cependant, celle-ci doit disposer de 8 Go de VRAM. Par conséquent, une RTX 3050 ou même une RTX 3060 6 Go ne répond pas à ces exigences. Cependant, cela ne devrait pas poser problème étant donné l’accès gratuit à ChatGPT 3.5, ou ChatGPT 4 via Copilot de Microsoft.

Vous pouvez télécharger Chat with RTX depuis le site officiel de NVIDIA (35 Go).