En 2012, NVIDIA commercialisait la dernière référence de carte graphique bi-GPU pour le grand public : la GeForce GTX 690, elle embarquait deux GPU GK104 et 4 Go de mémoire VRAM (2 Go par GPU). Mais depuis plus de 10 ans, ce genre de solutions multi-GPU a disparu, à quelques exceptions près puisqu’en 2014 est sorti l’AMD Radeon R9 295X2 ainsi que la NVIDIA GeForce Titan Z.

Seulement 7 ans du début à la fin des cartes bi-GPU

Techniquement, la première carte bi-GPU était la NVIDIA 7950 GX2 avec ses deux GPU G71 et son design en « sandwich » si singulier. Commercialisée en 2006, il s’agissait littéralement de deux 7950GT assemblées ensembles.

Il existait des cartes avec plusieurs chipsets 3D comme la 3DFX Voodoo 5, mais il ne s’agissait pas de GPU.

Du côté d’ATI (AMD maintenant), il faudra attendre la 3870×2 en 2008 pour voir le premier modèle bi-GPU chez les rouges.

À partir de là, à chaque génération de cartes graphiques, que ce soit chez ATI/AMD ou chez NVIDIA, nous avons eu le droit à une carte bi-GPU (sauf exception comme les GTX 400 avec Fermi). Ceci jusqu’à la GeForce GTX 690 en 2012.

En à peine 7 ans, la technologie des cartes bi-GPU fut abandonnée, du moins pour le grand public. Car AMD a proposé la Vega II Duo dédiée aux professionnels équipés de Mac Pro de 2019.

Pourquoi créer des cartes bi-GPU ?

Le but de la 7950 GX2 était de proposer une solution Multi-GPU sans avoir besoin d’une carte mère équipée de chipset NVIDIA compatible pour le SLI.

Le fonctionnement des cartes bi-GPU est donc le même qu’un SLI ou Crossfire, la seule différence c’est que tout se passe en interne sur une seule et même carte utilisant un seul port PCIe.

Pour la petite histoire, il était possible de faire un SLI avec deux 7950 GX2, ce qui donnait la toute première solution Quad-GPU.

L’utilisation d’un seul port PCIe permet d’économiser sur la carte mère et de rendre plus accessible le Multi-GPU.

Les cartes Bi-GPU, la fausse bonne idée du Multi-GPU ?

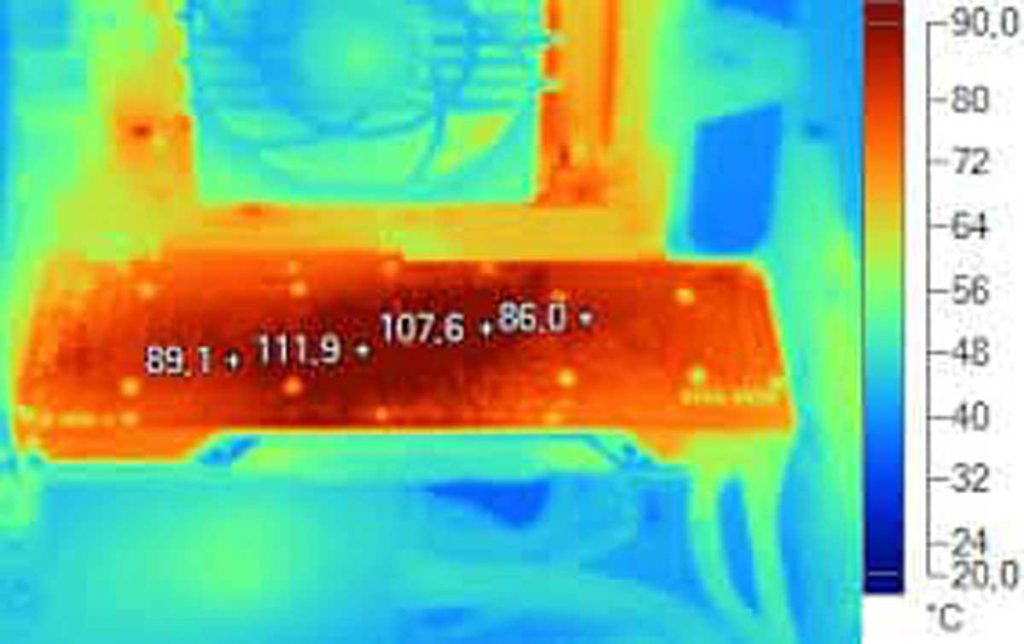

Il y a beaucoup de contraintes liées aux cartes bi-GPU. La première c’est le partage de la bande passante sur un seul port PCIe. Deuxièmement : les contraintes thermiques. En effet, deux GPU sur un seul PCB ça chauffe énormément et le manque de place fait qu’il est compliqué de refroidir correctement les GPU. Ce qui donne des températures de fonctionnement élevées et des cartes généralement très bruyantes. La chauffe entraîne aussi des cartes moins fiables.

Un autre défaut est lié aux deux premiers. Généralement, les cartes bi-GPU étaient moins performantes que les SLI ou Crossfire équivalentes.

Tout ceci mis bout à bout pourrait expliquer la fin de production de ce genre de cartes, il s’agissait finalement d’une fausse bonne idée pour proposer une solution multi-GPU plus abordable.

Euh la R9 295X2 est bi gpu et sortie il y a moins de 10 ans non ?

Tout à fait, j’ai rajouté la mention dans le premier paragraphe, Clément a oublié d’en parler 🙂

Ok merci pour la confirmation 😉 Et pour tous ces articles également ! Excellent travail de votre part 🙂

Suffit de lire lepremier paragraphe pour voir qu’il en parle…

« Mais depuis plus de 10 ans, ce genre de solutions multi-GPU a disparu, à quelques exceptions près puisqu’en 2014 est sorti l’AMD Radeon R9 295X2 ainsi que la NVIDIA GeForce Titan Z. »

La GTX 760 Mars? Vous l’oubliez aussi?

La GTX 760 n’a rien d’officiel lancé par nVidia, C’est Asus qui l’a fait de son coté