Conclusion : carte graphique NVIDIA RTX 4080 Founders Edition

Passons maintenant à la conclusion de ce test sur cette carte graphique NVIDIA RTX 4080 Founders Edition. Rappelons que l’entreprise au caméléon annonce cette carte comme deux fois plus puissante que la RTX 3080 Ti pour une consommation inférieure de 10% et un prix MSRP identique de 1199$ (sujet à développer dans l’encart du prix plus bas). Au niveau des spécifications techniques, nous sommes sur un GPU AD103-300 qui dispose de 9 728 CUDA Cores, 76 RT Cores de 3e génération et 304 Tensor Cores de 4e génération. Pour la configuration mémoire, nous sommes sur 16 Go de mémoire GDDR6X via des puces Micron. Avec un bus de 256-bits, la bande passante est donc de 716,8 Go/s. En revanche, en plus de l’augmentation des cœurs de tout type ainsi que leur efficacité, nous avons également une augmentation conséquente de la fréquence avec un Boost qui atteint désormais les 2 505 MHz. En pratique, selon les conditions et la charge, il n’est pas rare de voir des fréquences encore plus hautes en jeu sans passer par un OC.

Le TDP annoncé est de 320W et NVIDIA recommande une alimentation de 700W minimum. Notez que nous avons ici une connectique PCIe Gen5 sur la carte (12VHPWR). Pas de panique, si vous n’avez pas une alimentation compatible, en bundle est fourni un adaptateur 3*8-pins vers PCIe Gen5 (16-pins). Vous avez sans doute vu la débâcle sur cette connectique présente également sur la RTX 4090. Assurez-vous de bien enfoncer le câble dans le port jusqu’au bout et de ne pas tordre ou créer de contraintes sur les trois premiers centimètres du câble en question.

Pour parler des performances dans une utilisation gaming, face à une RTX 3090 Ti et en QHD nous avons sur notre panel de jeux +18,46% de performances avec notre RTX 4080. Une fois en UHD nous calculons +21,12% de gains. Des valeurs intéressantes face à une RTX 3090 Ti qui a été lancée à 2249 euros et qui est ensuite passée à 1329 euros. En revanche, précisons de suite que comme les RTX 3090/Ti, elle se destine à du gaming en 4K. Dans une définition en FHD, nous serons trop vite limités par le CPU (même avec un i9-12900K) et ce serait donc du gâchis d’utiliser une 4080 sans au minimum un écran 4K. En effet, par rapport à une RTX 3090 Ti nous mesurons seulement +13,26% de gains. Ces gains sont calculés sur les jeux en rastérisation, mais aussi en Ray Tracing et DLSS confondus.

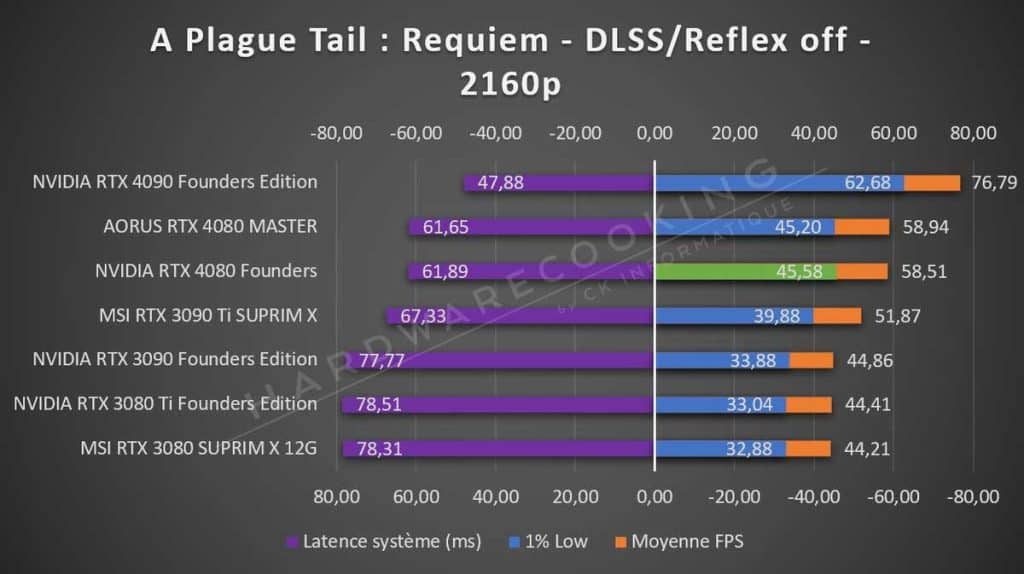

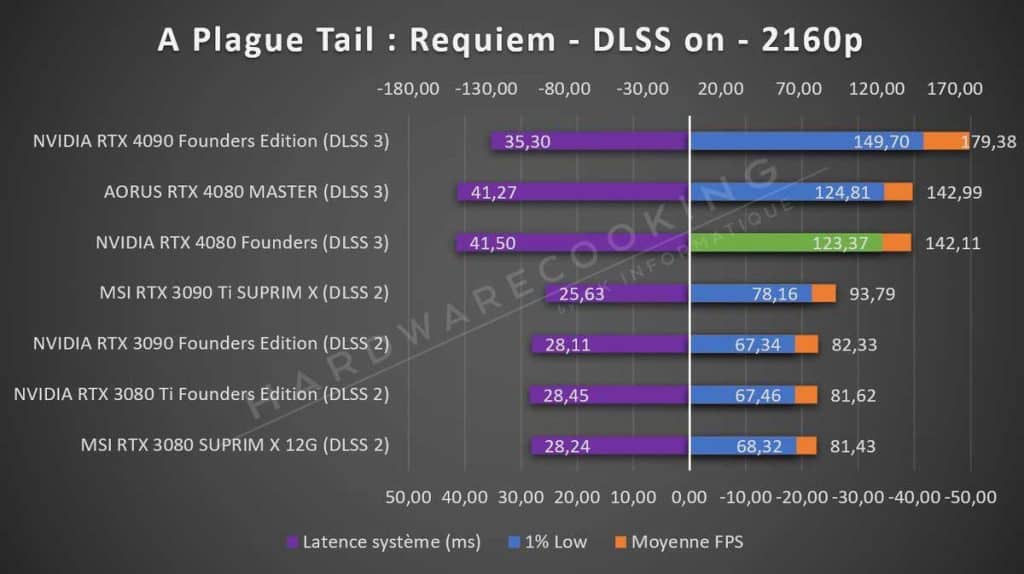

Si l’on regarde les performances du DLSS 3 face au DLSS 2 (RTX 3090 Ti SUPRIM X VS RTX 4080 Founders), nous mesurons +51,52% de gains pour A Plague Tail: Requiem, +29,4% sous F1 2022 ou encore +75,36% sous le titre Cyberpunk 2077. Cette nouvelle itération de la technologie chouchoute de la marque est donc efficace. Rappelons qu’elle combine le DLSS 2, le Reflex et le Frame Generation via les OFA. Si le Reflex est automatiquement combiné dans l’équation, c’est parce que Frame Generation augmente la latence, il faut donc combler au possible ce manque. En revanche, il faut maintenant que plus de jeux intègrent rapidement cette technologie.

Là où la carte va se montrer aussi très intéressante, c’est pour les utilisations professionnelles (calcul, rendu 3D, etc.). En effet, dès lors que c’est plus performant qu’une RTX 3090 et 3090 Ti, c’est forcément intéressant pour les créateurs de contenus et autres besoins spécifiques. Par exemple, pour les besoins en termes de rendu sur de lourds fichiers (DaVinci Resolve, Blender, OctaneRender, etc.). Les professionnels travaillant sur de gros projets sous de tels logiciels ont donc tout intérêt à passer sur de telles cartes graphiques puisque les temps de rendu sont considérablement réduits face aux plus grosses RTX 3000. Pour nous, c’est dans ce domaine que cette carte a le plus de sens. Tout le monde le sait, pour de telles entreprises, le temps, c’est de l’argent. D’autant plus que NVIDIA propose des pilotes spécifiques pour l’applicatif en plus de ses pilotes dédiés aux jeux vidéo.

Pour tester le système de refroidissement, nous avons lancé un stress test OCCT GPU 3D d’une durée de 45 minutes. À la fin de ce test, nous relevons la température maximale qui a ici été de 64,2 °C sur le GPU avec un hot spot à 77,1 °C. Pour comparer, c’est moins que beaucoup des cartes que nous avons passées en test sur ce protocole. NVIDIA s’est clairement amélioré sur le refroidissement de ses cartes. Mais il faut aussi préciser que la taille de la RTX 4080 est bien plus importante que la RTX 3080 ou même la 3080 Ti. En effet, pour vous donner un ordre d’idée nous sommes sur le design que nous avons découvert avec la RTX 4090 qui était à peu de chose près celui de la RTX 3090, mais avec quelques améliorations qui se sont révélées efficaces. Mais cela permet à la carte d’être mieux refroidie et donc également d’être plus silencieuse en charge. Notez aussi que nous ne testons pas les cartes graphiques dans un boîtier, mais sur une table de bench. Cela signifie qu’aucun flux d’air n’est présent. La carte graphique doit donc se débrouiller seule pour se refroidir. La température ambiante de la pièce est maintenue à 21 °C lors de nos tests.

Pour parler des consommations, nous relevons lors du stress test OCCT GPU 3D une consommation maximale sur le GPU de 290,1 Watts et jusqu’à 316,7 Watts sur l’ensemble de la carte graphique. Des consommations finalement très correctes compte tenu des performances. En effet, c’est même moins qu’une RTX 3090 Founders sur laquelle nous avons relevé 358,2W sur le même protocole ou encore 366,6W pour la RTX 3080 Ti. Sous Call of Duty nous relevons une consommation de 275W en 4K contre 450W sur la 3090 Ti SUPRIM X, 381W sur la 3080 SUPRIM X 12G ou encore 347W sur la RTX 3080 Ti et 342W sur la RTX 3090. Pour finir, sous Cyberpunk 2077 nous relevons 290W sans RTX/DLSS et 270W avec. Ce sont des consommations plus basses que les autres cartes de ce comparatif qui descend jusqu’à la RTX 3080 SUPRIM X 12G. Dernière précision, nos relevés sont réalisés sans OC, mais à stock comme elle est en sortie de boîte. Pour rappel, NVIDIA recommande un bloc d’alimentation de 700W pour cette RTX 4080.

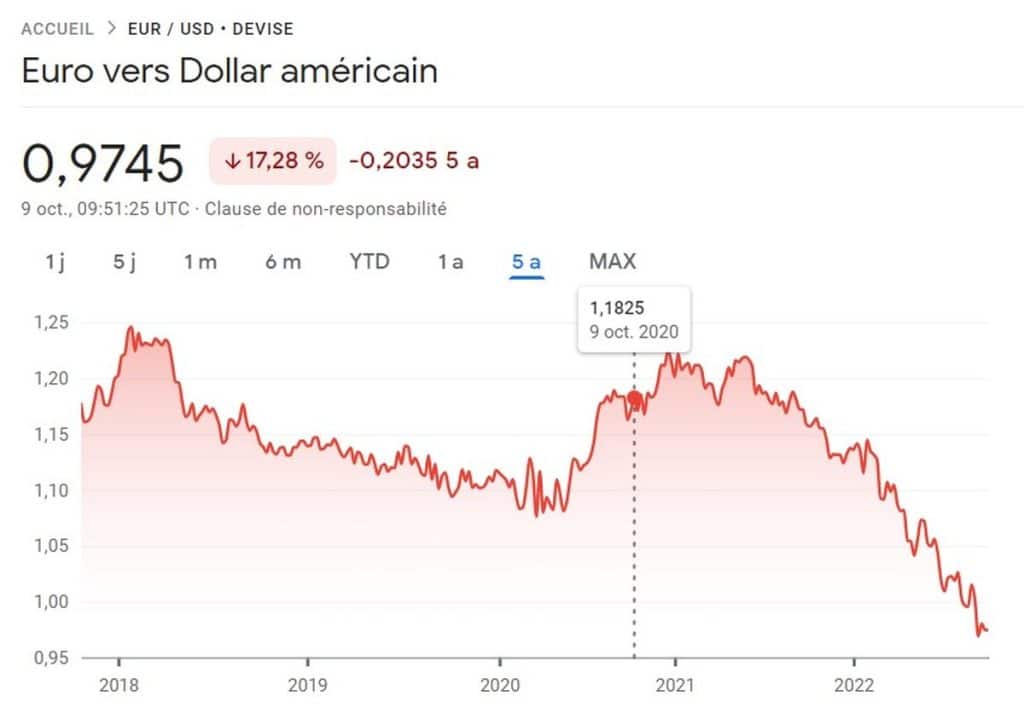

En matière de tarifications, c’est là que ça fait mal. En effet, même si cette RTX 4080 est annoncée au même prix que la RTX 3080 Ti à son lancement, c’est-à-dire 1199$, en France ça se passe différemment. En effet, rappelons que la RTX 3080 Ti est arrivée ici au prix de 1269 euros. En revanche, la RTX 4080 arrive au prix de 1469 euros, soit une augmentation de +15,76% (+200 euros). Précisons une chose importante. Entre la sortie de la RTX 3080 Ti et cette RTX 4080, la valeur de l’euro a fortement chuté face au dollar, ce qui influe forcément sur nos prix. Et puis, inflation toussa toussa… Bref, le prix de 1469 euros est clairement trop élevé pour nous et pour la majorité des utilisateurs également d’ailleurs. D’autant plus qu’en face AMD annonce des prix très intéressants de 899$ pour la Radeon RX 7900 XT et 999$ pour la RX 7900 XTX. Il faudra néanmoins attendre mi-décembre pour voir les performances de ces cartes de manière concrète.

De plus, la tarification des modèles customs haut de gamme (ASUS ROG Strix, MSI SUPRIM ou encore AORUS MASTER) vont encore s’envoler comme on a pu le voir dans plusieurs fuites ces derniers jours.

Pour finir, en raison du prix, il est difficile de se décider sur une note. Si nous devions prendre en compte le prix, ce ne sera certainement pas une médaille d’Or, mais plutôt une médaille HC d’Argent. Mais sans prendre en considération le prix, nous avons tout de même une RTX 4080 qui est plus performante qu’une RTX 3090 Ti pour une consommation bien moindre et là on partirait sans hésiter sur une médaille HC d’Or. Nous aurions même pu passer à la limite de la médaille coup de cœur si nous avions des dimensions plus contenues.

Pour

- Performances en applicatif

- Performances en jeu impressionnant (rastérisation, Ray Tracing et DLSS)

- Le rapport performance par Watts est excellent !

- 16 Go de mémoire GDDR6X

- Architecture Ada Lovelace

- Une consommation très maitrisée

- Des températures mieux maitrisées que sur les RTX 3000

- Connectique en PCIe Gen5 (moins de câbles)

- L’encodage et le décodage qui s’améliore encore

- Le DLSS 3 qui performe

Moins

- Un prix clairement trop élevé pour une carte de la série XX80

- De grosses dimensions pour une carte XX80, mais ça permet un bon refroidissement

Avant de partir, n’oubliez pas de rejoindre notre serveur Discord et de nous suivre sur Facebook, Twitter, TikTok et de vous abonner à notre chaîne YouTube. Enfin, si vous désirez nous soutenir, voici comment vous pouvez nous aider.

- Introduction et caractéristiques techniques

- Architecture Ada Lovelace

- Benchmarks

- Rendus 3D

- Far Cry 6 et Assassin’s Creed Valhalla

- F1 2022 et Call of Duty: Black Ops Cold War

- Total War: THREE KINGDOM et Watch Dogs: Legion

- Shadow of the Tomb Raider et Cyberpunk 2077

- Performances relatives en jeu (1080p, 1440p et 2160p)

- Températures, latences et consommations

- Conclusion

A 1500€ la carte c’est clairement pas les gamers qui sont visés.

A voir les rtx 4070 mais si c’est pour avoir +15% de perf en plus en 1440p hors dlss 3 l’intérêt va être très limité, autant attendre la techno du concurrent qui sera ouverte a toutes les cartes graphiques.