GIGABYTE RTX 4090 GAMING OC 24G : températures, consommations et latences

Le logiciel très connu OCCT avec son stress test GPU 3D va nous permettre de faire chauffer la carte graphique pour relever les températures, mais aussi la consommation. Pour ceci, nous lançons un test OCCT GPU 3D durant 45 minutes avec la détection d’erreur activée et une complexité de shaders à 3. Évidemment, nous faisons ce test dans une pièce à température contrôlée qui est maintenue à 21°C.

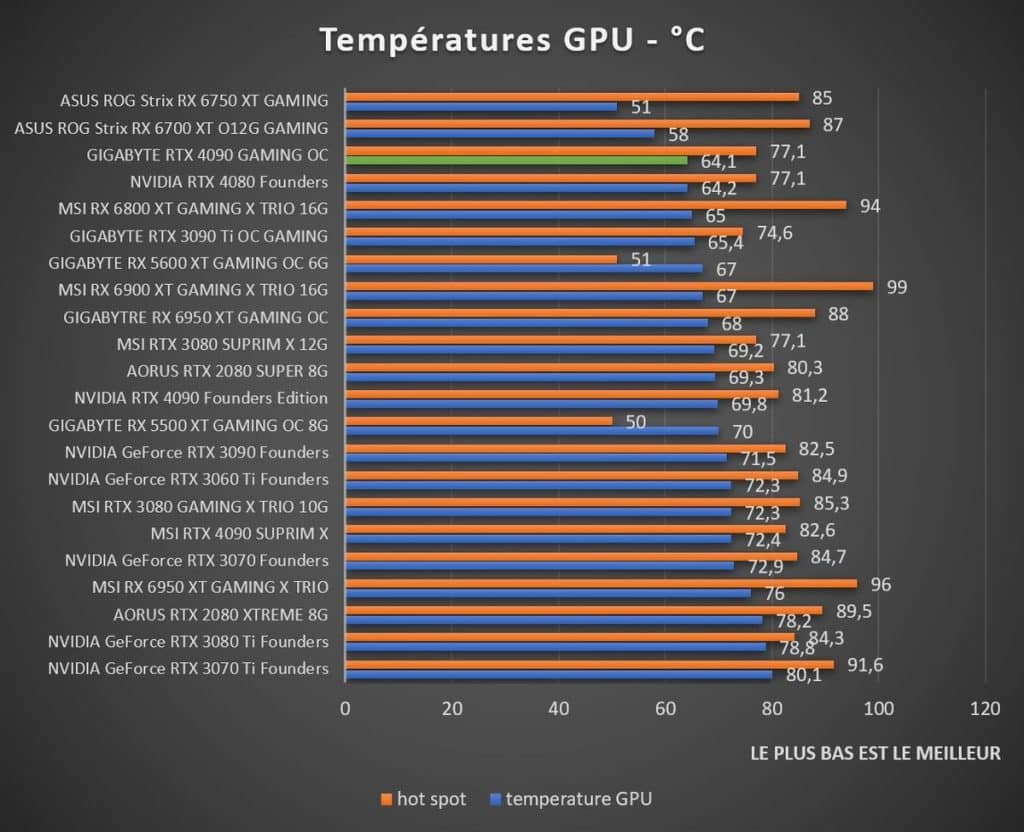

Comme nous sommes sur une table de bench, notre carte graphique ne bénéficie pas d’un flux d’air apporté par un châssis et ses ventilateurs. Nous nous servons du logiciel GPU-Z pour avoir les relevés de températures via les sondes, ainsi nous obtenons 64,1 °C sur le GPU et 77,1 °C pour le Hot Spot. Des températures finalement pas aussi élevées que ce à quoi nous nous attendions et c’est une très bonne surprise.

En regardant de plus près les températures au niveau de la backplate via la caméra thermique, nous relevons une température de 52,1 °C au point le plus chaud. Là encore, c’est très correct d’autant plus que ce n’est même pas directement sur la backplate, mais sur la partie du PCB proche de la connectique du PCIe. Concrètement, les backplates brulantes au toucher ce n’est plus automatique sur cette génération de cartes graphiques.

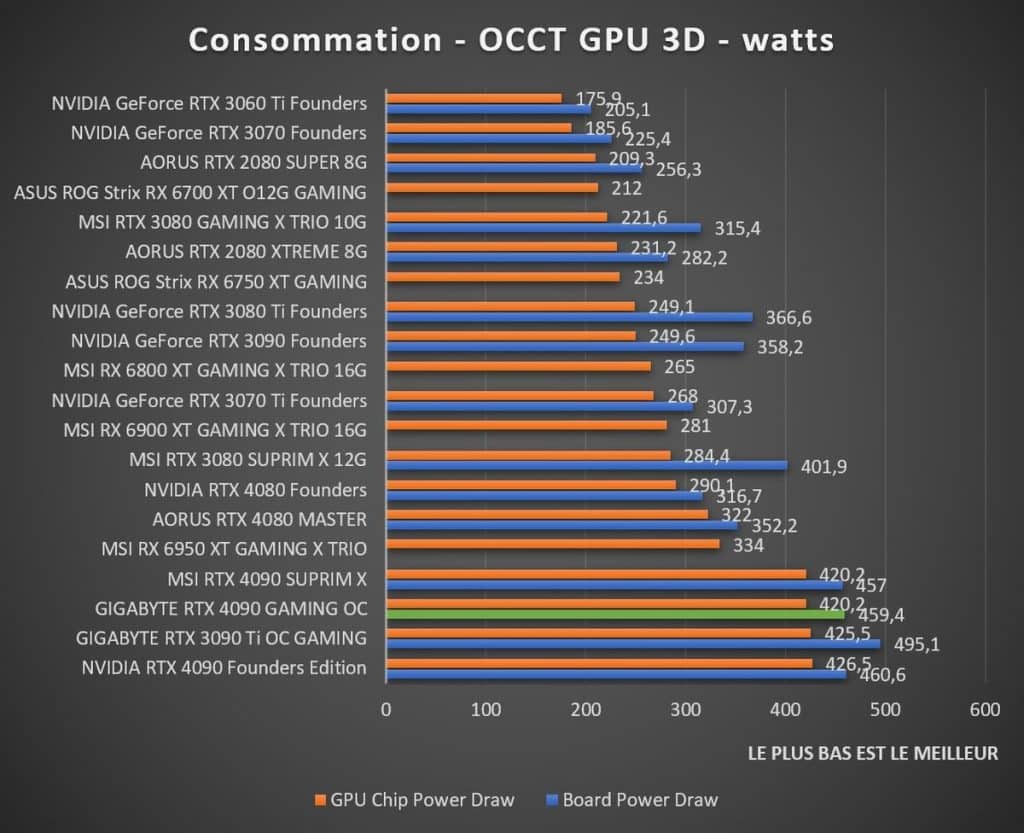

GPU-Z nous permet aussi de voir les consommations de la carte graphique avec précision. On constate ainsi un pic de consommation de 459,4 Watts pour l’ensemble de la carte graphique (Board Power Draw) et 420,2 Watts pour le GPU seul. Il est important de préciser que, comme on le voit sur le graphique, notre RTX 3090 Ti a présenté une consommation supérieure de 495,1 Watts sur l’ensemble de la carte, ceci pour des performances finalement moindres à notre RTX 4090 (et même à la RTX 4080 qui consomme encore moins). Le rapport performance par Watts est donc très grandement amélioré puisqu’elle fait mieux pour une consommation inférieure.

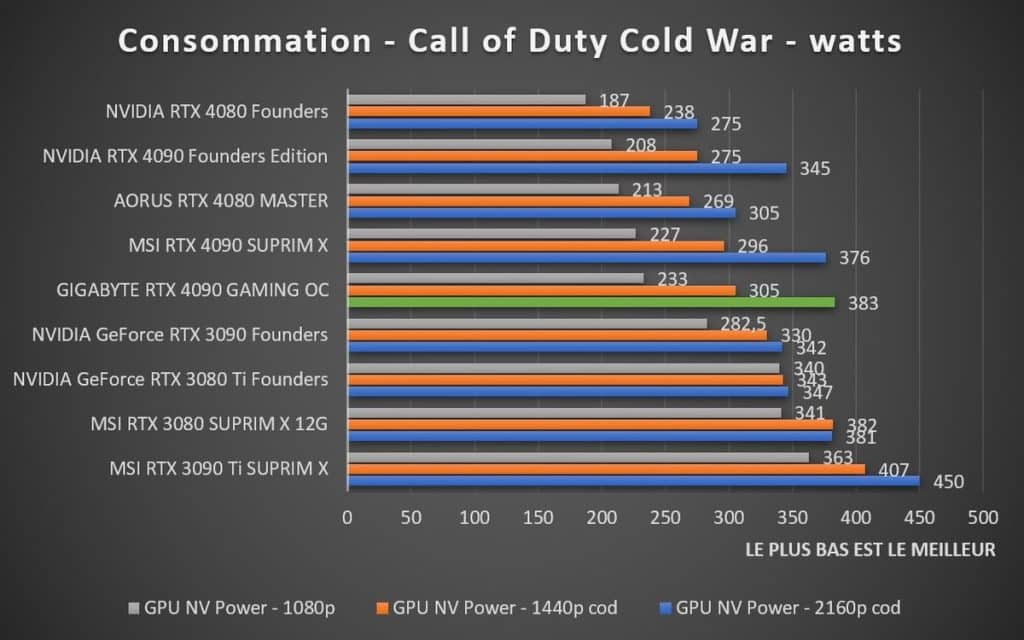

De même, arrivés en jeu sur Call of Duty Black Ops: Cold War, la carte se tourne un peu les pouces si l’on n’est pas en 4K UHD. De ce fait, en 1080p la consommation est de seulement 233W et 305W en 1440p. En 4K UHD, la seule définition qui rend honneur à la RTX 4090, nous relevons 383W. En comparaison, nous relevons 450W sur la 3090 Ti custom (et 342W sur la RTX 3090 Founders). Précisons que ce relevé se fait en rastérisation, hors Ray Tracing et DLSS.

Les latences avec NVIDIA RLA

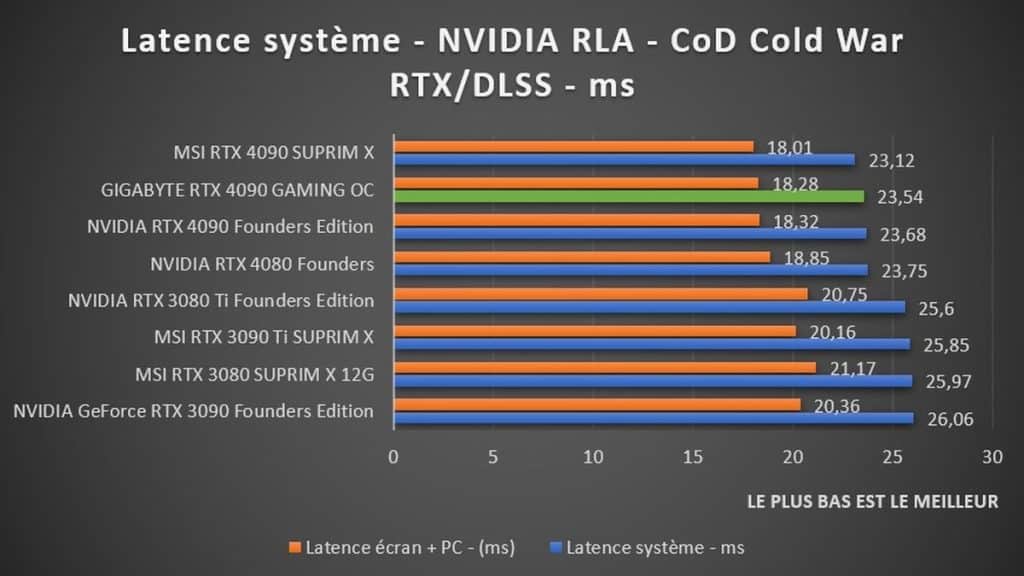

Pour tester les latences avec notre écran RLA 360 Hz, nous passons sur le jeu Call of Duty: Black Ops Cold War. Concrètement, nous relevons deux mesures : la latence écran + PC et la latence système complet de bout en bout en partant du clic de la souris qui est compatible avec cette technologie NVIDIA RLA (Reflex Latency Analyzer). Pour en venir à notre RTX 4090 de GIGABYTE, nous relevons 23,54 ms pour le système complet à chaque tir (entre le moment où l’on clique sur la souris jusqu’à l’affichage de l’action à l’écran). Pour l’écran + PC, nous sommes à 18,28 ms. Les différences sont minimes, car notre écran RLA est en FHD et nous avons bien vu dans nos benchmarks que cette définition bride clairement des cartes aussi performantes, le jour où nous aurons le RLA sur des écrans 4K, ces relevés seront bien plus intéressants. En attendant, nous sommes en train de voir pour nous équiper d’un écran QHD RLA en 360 Hz pour ce test spécifique qui sera beaucoup plus révélateur.

Passons maintenant à la conclusion de ce test sur cette carte graphique GIGABYTE RTX 4090 GAMING OC.

Lire la suite

- Introduction et caractéristiques techniques

- Architecture Ada Lovelace

- Benchmarks

- Rendus 3D

- Far Cry 6 et Assassin’s Creed Valhalla

- F1 2022 et Call of Duty: Black Ops Cold War

- Total War: THREE KINGDOM et Watch Dogs: Legion

- Shadow of the Tomb Raider et Cyberpunk 2077

- Performances relatives en jeu (1080p, 1440p et 2160p)

- Températures, latences et consommations

- Conclusion